隨著OpenAI、Anthropic、Google和微軟等公司的生成式AI及大語言模型(LLM)用戶量呈指數級增長,企業IT安全決策者正努力跟上AI技術的快速發展步伐。非營利組織OWASP最新發布的《LLM AI網絡安全與治理清單》(PDF)正是為此而生。

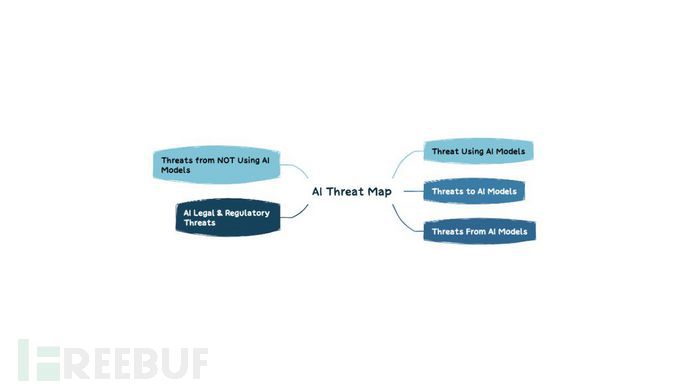

LLM威脅分類體系

鑒于AI領域涉及面廣泛,OWASP清單主要幫助管理者快速識別生成式AI和大語言模型的關鍵風險并采取補救措施,確保企業具備基本安全控制能力來安全使用相關工具和服務。OWASP強調該清單將隨技術成熟度持續更新,其專家團隊將LLM威脅劃分為以下類別:

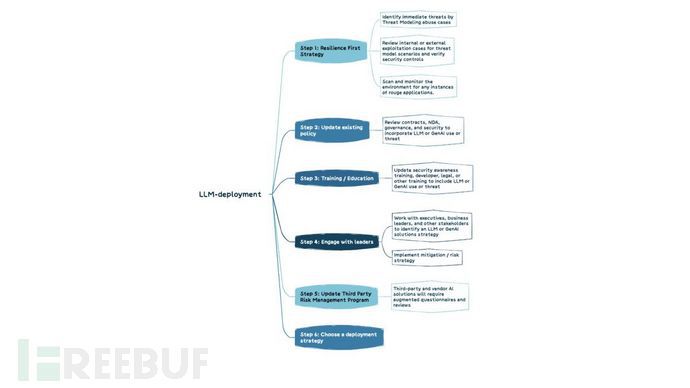

制定LLM戰略時,企業需重點應對生成式AI帶來的獨特風險,通過組織治理和安全控制加以緩解。OWASP建議采用六步法構建有效的LLM部署策略:

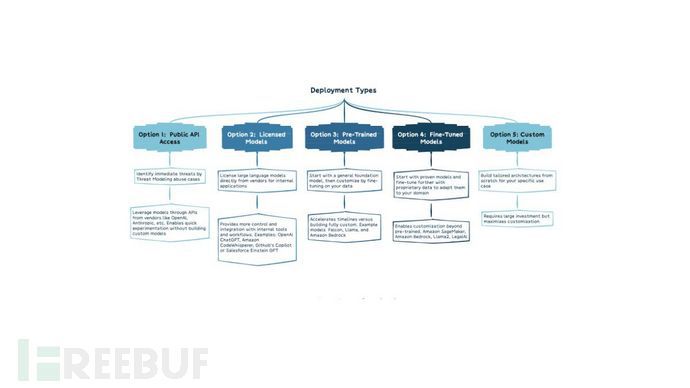

針對不同類型的LLM部署方案,OWASP也提供了詳細考量框架:

OWASP AI安全清單詳解

(1) 對抗性風險

涵蓋競爭對手和攻擊者雙重維度,包括分析競對如何運用AI提升業務表現,以及更新事件響應計劃等內部流程以防范AI相關安全事件。

(2) 威脅建模

基于"安全設計"原則,需考慮攻擊者如何利用LLM加速漏洞利用、企業如何檢測惡意AI行為,以及如何實施系統防護措施。

(3) AI資產清點

遵循"未知即不可保護"原則,需全面記錄自研解決方案和第三方工具,明確責任歸屬。建議將AI組件納入軟件物料清單(SBOM),按敏感度分類數據源,并建立工具準入退出機制。

(4) AI安全與隱私培訓

通過系統化培訓使員工理解AI/LLM技術原理與安全挑戰,培育信任透明的組織文化,從根本上杜絕"影子AI"現象。

(5) 商業價值論證

避免跟風炒作,需建立清晰的AI商業用例,如同當年云計算推廣時的戰略規劃。

(6) 治理框架

通過RACI矩陣明確AI項目權責,制定企業級政策和流程,實現可問責的管理體系。

(7) 法律合規

需法律團隊介入評估產品擔保條款、最終用戶許可協議(EULA)和知識產權風險等關鍵法律議題。

(8) 監管應對

密切關注歐盟《人工智能法案》等新興法規,識別適用的合規要求。

(9) LLM方案實施

具體控制措施包括:實施訪問控制、保護訓練管道、映射數據流、識別LLM及供應鏈漏洞,建議定期進行第三方審計、滲透測試和代碼審查。

(10) 測試評估驗證(TEVV)

參照NIST AI框架建議,持續開展功能測試、安全驗證及可靠性評估,覆蓋AI模型全生命周期。

(11) 模型與風險卡片

通過標準化文檔披露模型架構、訓練方法和性能指標,提升系統透明度,主動應對偏見、隱私等倫理問題。

(12) 檢索增強生成(RAG)

通過優化預訓練模型和增量訓練,提升LLM在特定數據源的檢索能力,最大化企業應用價值。

(13) AI紅隊演練

通過模擬攻擊檢驗防御體系有效性,但需明確演練邊界要求,避免引發合規風險。